分享

点赞

8

评论

1

DeepSeek-V3

99278星

DeepSeek 开源的混合专家模型

项目来源:

项目简介

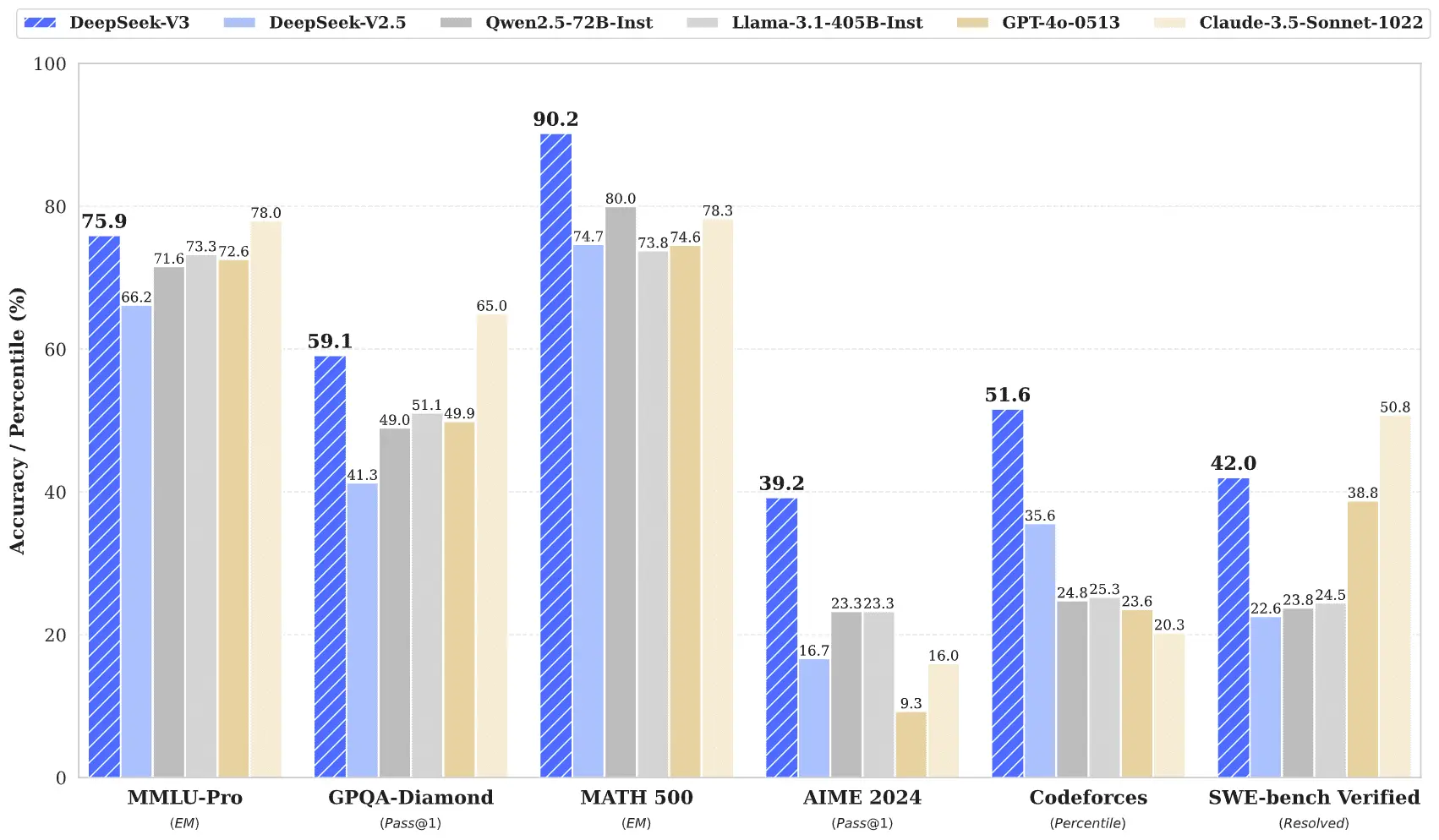

这是一个基于混合专家(MoE)和多头潜在注意力(MLA)架构的开源大语言模型,在数学推理、代码生成等复杂任务中表现优秀。该模型总规模达 671B 参数,但每个 token 只激活其中的 37B 参数。即在处理输入时,并非所有“专家”都参与计算,而是选择一部分专家进行处理。通过激活部分参数(37B)完成计算,从而降低了训练和推理的成本。